さくらの自前データセンター紹介(堂島IDC編)

さくらのナレッジをご覧の皆様、はじめまして。

さくらインターネットにてデータセンター運用を担当している小林と申します。

今回、大阪某所にある当社の堂島データセンター、及びデータセンター内で取り扱っているサーバについてご紹介します。

2004年に開設された堂島データセンターでは、当時の特徴として自社製のオリジナルサーバを採用し、レンタルサーバや専用サーバサービスを提供していました。

自社製サーバを採用していた理由はいくつかありますが、その1つとしてサービスを構築していく上で発生する課題を、自社製サーバならではのスピード感で解決し、次に繋げていく事ができるという点があります。

どうすれば最適な環境でサービスをご提供できるのか。試行錯誤の日々の中で、サーバも様々に形を変えていきました。

以下、当時採用されていた自社製サーバ機器の変遷についてご紹介します。

自社製オリジナルサーバ

6U5ブレード

2004年当初から利用していた、6U5ブレードと社内で呼称しているサーバです。

2004年当初から利用していた、6U5ブレードと社内で呼称しているサーバです。

その名の通り、6Uの幅があるエンクロージャーに、5台のサーバを収容する形状になっています。46Uラックには、最大で30台程度のサーバの収容が可能でした。

サーバへの設置やメンテナンス性は悪くありませんでしたが、ラックへの集約性の不足から、新しい形状のサーバの作成が模索されました。

4.5U8ブレード

6U5ブレードの思想を発展させた、4.5U8ブレードと社内で呼称しているサーバです。

6U5ブレードの思想を発展させた、4.5U8ブレードと社内で呼称しているサーバです。

6U5ブレードのサーバ機器と比べ、省電力CPUを採用し、1ラックあたりの収容数が72台と高集積を実現しました。

しかしながら、高収容故の問題点としてLANケーブルのケーブリングに難があり、ご覧のように非常に見苦しい配線になっているラックがありました。

高収容化を進めていくためには、ケーブリングの問題を解決しないといけない事を改めて痛感したサーバでした。

2UHalfサーバ

こちらは2Uサイズのサーバです。 一見するとそれ以外の特徴がないようにも見えますが、実はHalfサイズとなっています。

こちらは2Uサイズのサーバです。 一見するとそれ以外の特徴がないようにも見えますが、実はHalfサイズとなっています。

ラックの前面、背面にそれぞれ設置できるので、46Uラックに40台程度収容する事が可能です。

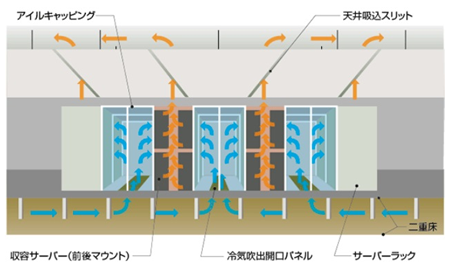

アイルキャッピング

2009年、堂島データセンターにてアイルキャッピングを採用したホスティング専用フロアを増床し、自社製のオリジナルサーバだけでなく、ラックやフロアの設計も含めた新たな試みを行いました。

アイルキャッピングは、NTTファシリティーズ社の工法です。

アイルキャッピングは、NTTファシリティーズ社の工法です。

当社においては、旧来ラック下部からの吹き出し方式にてサーバを冷却していましたが、新たにこのアイルキャッピングでの冷却方式を採用する事により、省エネルギー化を進めるとともに、より高収容にてサーバを設置する事が出来るようになりました。

サーバへの給気(低温)とサーバからの排気(高温)を物理的に分離して、効率的な空調環境を実現する事が可能です。

サーバの収容効率を高め、省エネルギーとデータセンタースペースの有効活用を図りました。

当時としては高開口率で通風性に優れたデータセンター専用ラックを採用し、空調効率を向上させています。

データセンター内

上図は改善前のキャッピング環境です。

上図は改善前のキャッピング環境です。

扉はジッパー式となっており、機器の搬入の際は、開閉が大変でした。

また、ジッパー式は下部に若干隙間が空くため、キャッピング内の冷気が漏れることもあり運用には気を使いました。

下図は改善後のキャッピング環境です。

機器搬入の際、扉の開閉が非常に楽になりました。

機器搬入の際、扉の開閉が非常に楽になりました。

また、キャッピング内の冷気が漏れることなく、運用可能となりました。

※床の開口も可変することが可能なため、状況により開口率の調整が簡単にできます。

それでは、アイルキャッピングの採用と共に導入が進められたサーバ群をご紹介します。

1UHalfサーバ

社内では1UHalfサーバと呼称されるサーバです。

社内では1UHalfサーバと呼称されるサーバです。

当時、アイルキャッピングを導入する際に、前後吸気ができるように特別に開発したサーバです。

また、ラックの前後からマウントすることで高収容を実現しました。1ラックあたり最大60台の設置が可能です。

1Uクォータサーバ

社内では1Uクォータと呼称されるサーバです。

社内では1Uクォータと呼称されるサーバです。

このサーバも前面・背面ともに設置可能で、前後合せ1Uあたり合計4台が設置できます。

当時、アイルキャッピングを導入する際に、前後吸気ができるように特別に開発したサーバで、1ラックあたり最大120台の収容が可能です。

ラックのサーバ収容密度が高くなれば、当然ラック内で使用するケーブルの本数も増えます。

大量のネットワークケーブルは、アイルキャッピングで想定している気流を乱すため、この管理は頭を悩ませる問題です。

当時はアイルキャッピング自体が新しい工法であったため、ケーブリングの手法や、使用するLANケーブルの選定など、改善できるところはないか日々模索を続けていました。

また、アイルキャッピングはサーバからの排気(高温)と給気(低温)を分けて管理する事により、空調効率をあげる手法となりますが、サーバとサーバの間にはどうしても隙間ができてしまいます。

この問題を解決する為、熱の回り込みを防止するヒートシャッターを取り付け運用していました。

どのような形状、素材のヒートシャッターを使用するべきか。 ヒートシャッターに関しても頭を悩ませる課題でした。

以下が当時から現在までのラック内の状況です。

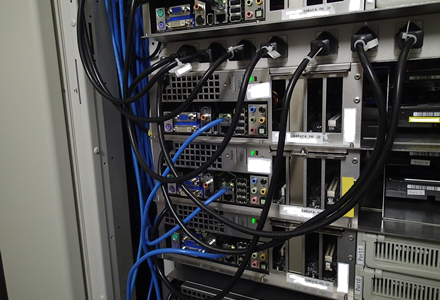

ラック内(改善前)

見えにくいのですが、ラック内部の両サイドに金属製のヒートシャッターを取り付けています。

見えにくいのですが、ラック内部の両サイドに金属製のヒートシャッターを取り付けています。

金属製のヒートシャッターは柔軟性にかけ、NICを複数使用する場合には、ラック側面にケーブルを逃がすところがなくなり、吸気面にLANケーブルが干渉し吸気に悪影響を及ぼします。

また、LANケーブル数が増加すると通常のUTPケーブルを使用しているため、視認性が低く、且つ電源プラグに抜け止め防止もないので、メンテナンスの際は誤って抜けることがないよう非常に気を使って作業をしています。

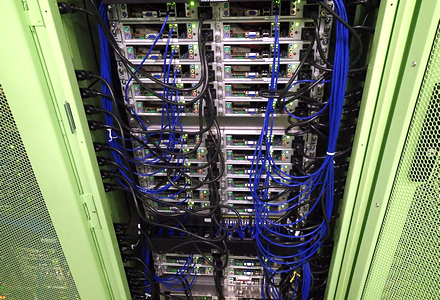

ラック内(改善後)

前述にて問題があった部分の改善を検討した結果、以下の改善を行いました。

前述にて問題があった部分の改善を検討した結果、以下の改善を行いました。

- ヒートシャッターは難燃性の布ヒートシャッターを採用

- UTPケーブルは細系ケーブルを採用

- サーバ本体へ簡易的なケーブルマネジメントを導入

- サーバへ電源プラグ抜け落ち防止の導入

結果、ラック内部の視認性も向上し、メンテナンスの際の負荷が軽減しました。

また、ケーブル類がサーバの吸気面に干渉が少なくすることで、効率よく冷気が吸気され、効果的な運用ができるようになりました。

保守作業のご紹介

データセンターやサーバのご紹介ばかりとなりましたので、ここからは実際の保守作業を、一部ご紹介します。

堂島データセンターで承っている代表的な保守作業として、「サーバ再起動」があります。

現在、当社でサービス提供している【 さくらの専用サーバ 】では、IPMIを利用したリモートコントロール機能をご利用いただけます。

リモートコントロールでは、サーバの再起動も実施できますので、【 さくらの専用サーバ 】 での再起動依頼は、それほど多くはありません。

当時、堂島データセンターにて採用されていたサーバ機器には、IPMI機能がありませんでしたのでサーバリブート依頼が現在より頻繁にありました。

では、実際のリブート作業をご紹介いたしましょう。

リブート作業

シンプルな作業となりますが、1回のミスも許されない作業となります。

指差呼称等を徹底し、ミスを防止していますが、それでも稀にミスが発生します。

チェックシートを利用し、指差呼称の際は確認事項を意識化するよう指導に努めていますが、長期的な運用の中で形骸化しがちになります。

これらを防ぐ手段として、第三者によるダブルチェックの実施を検討しました。しかしながら、多数あるご依頼全てに常に複数体制で実施することは困難であります。

このような問題を解消するため、現在ではタブレット端末を利用したダブルチェックを試験的に実施しています。

タブレット端末を利用したダブルチェックは、対象機器を動画で写し、通信しながら他の待機人員へ確認を依頼します。

このようにすることで作業担当者が確認作業を見落とした場合でも、第三者が見落としを指摘することで防止できると考えています。

おわりに

今回は当社、堂島データセンター(大阪)について簡単に説明させていただきました。

反省点など多くありますが、あきらめることなく、今後も様々なことにチャレンジし、運用品質の向上に努めていきたいと考えています。

最後まで御覧いただき、ありがとうございました。