gpt-oss-120b を試す!高火力 DOK で始めるコンテナ型GPUクラウド活用

はじめに

さくらインターネットの平山です。2025年8月、OpenAI からオープンウェイト言語モデル gpt-oss-120b と gpt-oss-20b がリリースされました。

今回は、コンテナ型GPUクラウドサービス 高火力 DOK に gpt-oss モデルを vLLM 推論サーバー上で動作させ、Open WebUI を通してインタラクティブに利用する方法をご紹介します。

gpt-oss とは?

gpt-oss は、OpenAI が公開したオープンウェイトの大規模言語モデルであり、外部の推論 API に依存せず自前環境で運用できるため、機密性の高いシステムやオンプレミス環境でも安心して利用できます。研究機関での検証や企業のクローズド環境での業務活用など、幅広いユースケースを想定しています。

高火力 DOK とは?

高火力 DOK は、事前に準備した Docker イメージをクラウド上で実行できるマネージドなコンテナー型 GPU クラウドサービスです。くわしい操作方法などは過去の記事、「【生成AIに触れてみよう】 高火力 DOKことはじめ #1 〜Dockerイメージ作成環境の構築〜」などもぜひご覧ください。

vLLM とは?

LLM を OpenAI 互換の API サーバーとして提供してくれるオープンソースライブラリです。HuggingFace とシームレスに連携可能で、公式の Docker イメージも提供されています。

高火力 DOK で gpt-oss を実行する方法

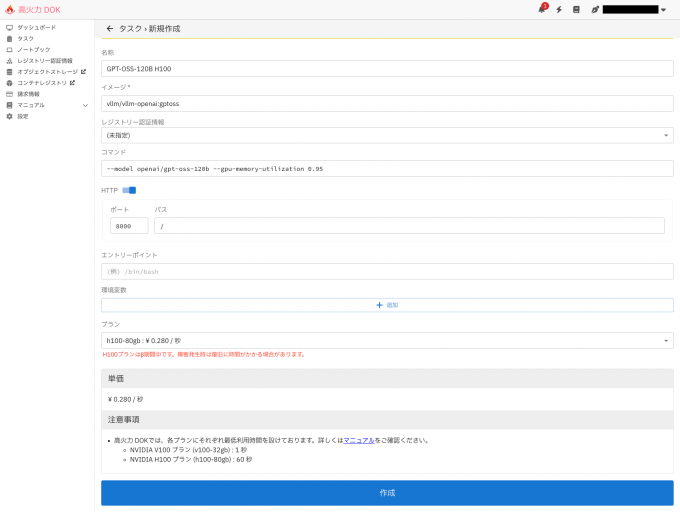

高火力 DOK のタスクを新規作成

高火力 DOK のコントロールパネルから タスクを新規作成 します。

イメージ は公式の vllm/vllm-openai:gptoss を指定します。

コマンド に --model openai/gpt-oss-120b --gpu-memory-utilization 0.95 を指定します。オプションは以下の意味を持ちます。

--model: HuggingFace から指定したモデルを自動でダウンロードします。--gpu-memory-utilization: GPU メモリの消費率を制限できます。

HTTP トグル をオンにし、ポートは 8000 で設定してください。

プラン は h100-80gb を指定し、作成を押します。

gpt-oss は MXFP4 形式というデータ形式を採用しています。この形式にネイティブに対応しているのは NVIDIA H100 以降の GPU であるため、ここでは h100-80gb を選択します。

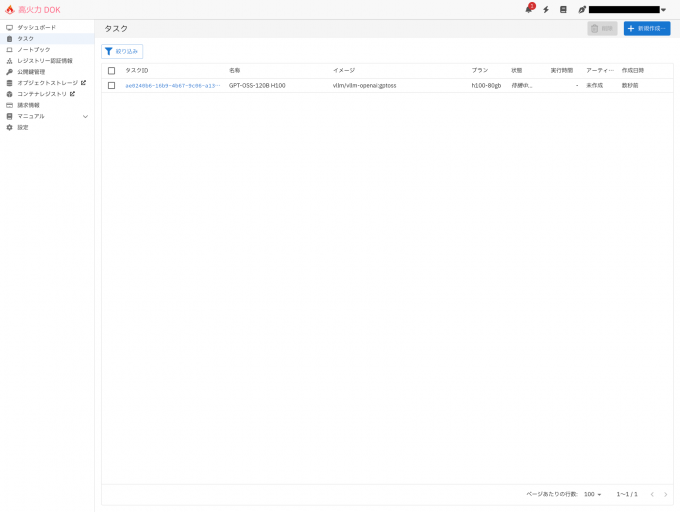

タスク画面では実行履歴や現在稼働中のタスク一覧を確認できます。

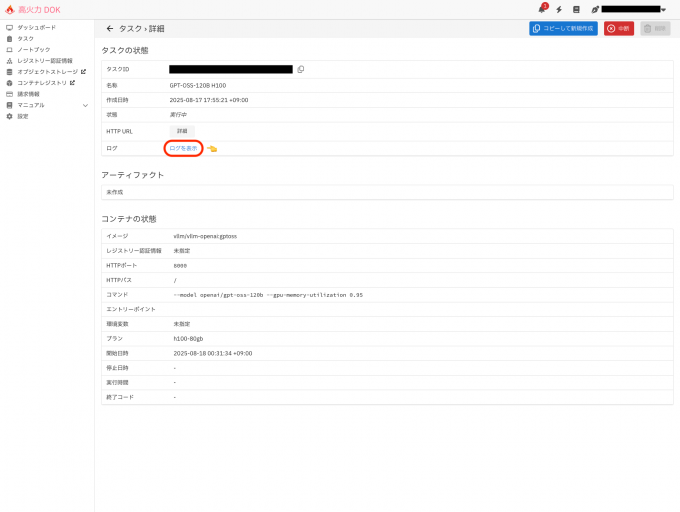

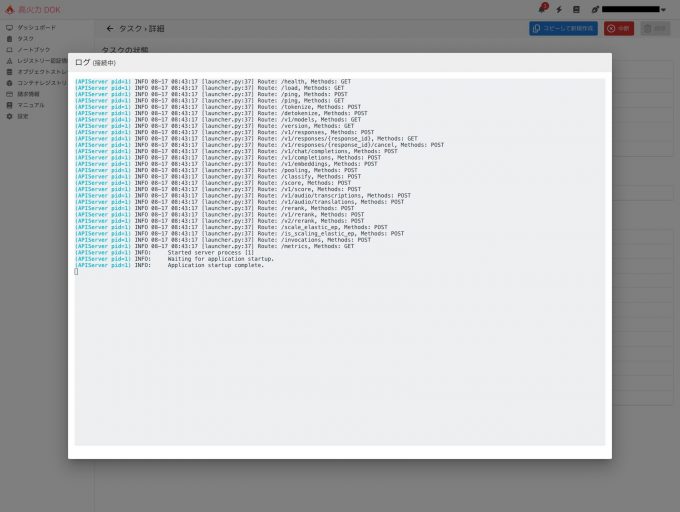

作成したタスクの タスクID をクリックすると、ログを確認可能です。

Application startup complete. が表示されれば起動成功です。

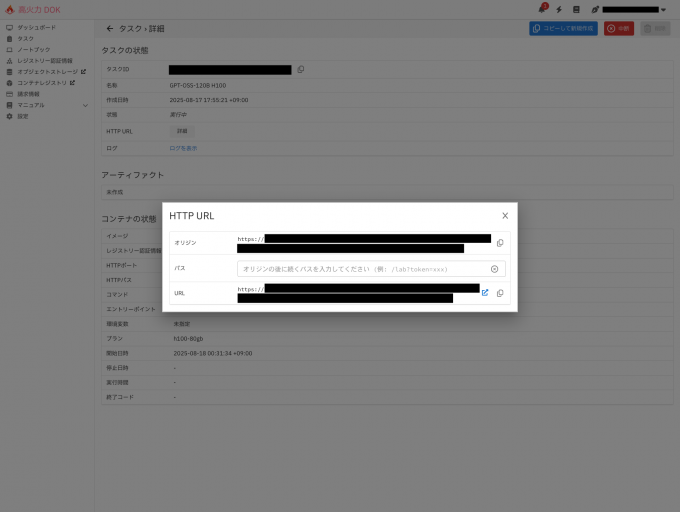

HTTP URL の 詳細 をクリックし、オリジンの URL を控えておいてください。

続いて、起動した LLM と会話するためのインターフェース Open WebUI をローカルに構築します。

Open WebUI とは?

完全オフラインで動作可能な、LLM を操作するためのオープンソース Web インターフェースです。Ollama や vLLM など OpenAI 互換 API サーバーと接続し、対話型の UI を提供します。

Open WebUI の起動方法

公式の Docker イメージが提供されています。Docker コマンドが使える環境で、以下を実行してください。(OPENAI_API_BASE_URL は高火力 DOK タスク詳細画面で控えた URL を指定してください)

docker run -d \

--name open-webui \

-p 3000:8080 \

-v open-webui:/app/backend/data \

-e OPENAI_API_BASE_URL=https://***.container.sakurausercontent.com/v1 \

--restart always \

ghcr.io/open-webui/open-webui:main起動後、http://localhost:3000 にアクセスし「開始」をクリックします。

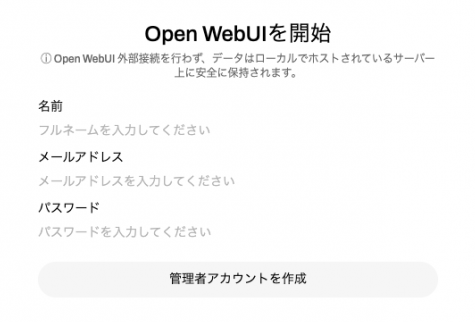

必須情報を入力し「管理アカウントの作成」を押します。

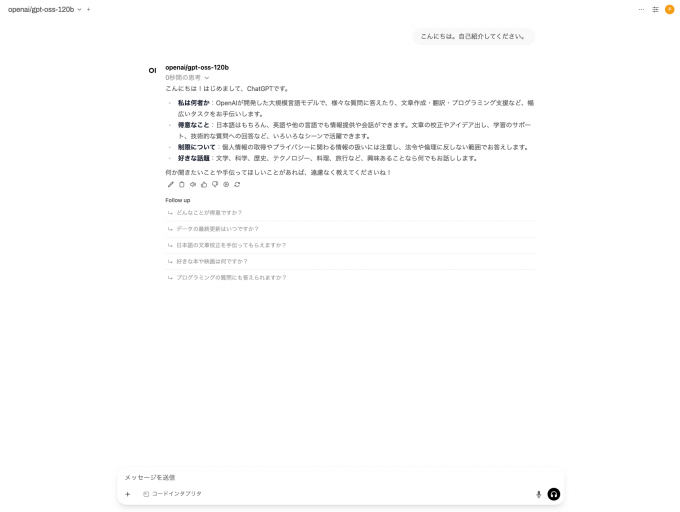

ログインすると、すでに openai/gpt-oss-120b が選択されています。

さっそく会話してみましょう!

まとめ

今回は 高火力 DOK 上で gpt-oss を立ち上げ、Open WebUI でモデルと会話する方法をご紹介しました。

gpt-oss-120b は 公式評価 によると、OpenAI o4-mini に匹敵、もしくはそれ以上 の性能を発揮します。また、完全クローズドな環境で稼働するため、入力した情報が外部モデルの学習に利用されることもありません。

この記事が皆様の AI 活用の一助となれば幸いです。