さくらのAI Engine×LINE Botで社会の課題を安全にDXする

こんにちは、さくらのナレッジ編集部です。2025年11月5日、Blooming Camp by さくらインターネットで開催された LINE Developer Community主催のイベント「さくらのAI EngineとLINE Botで社会の課題を安全にDXしよう!」に参加しました。テーマは、さくらのAI EngineとLINE Botを組み合わせて、生成AIの価値を実際のサービスとしてユーザーに届けるための実装プロセスを学ぶこと。登壇者の説明を聞きつつ、参加者が手を動かしながら体験できる内容でした。

ハンズオンのゴール

さくらインターネットが提供するさくらのAI EngineとLINE Botを連携し、RAGを利用して大阪市の学校給食データを参照し、「今日のメニュー」「材料」などの質問にLINE上で答えられるBotを構築することが、本ハンズオンの到達点でした。

さくらのAI Engineとは

まずは、さくらインターネットの亀田さんからさくらのAI Engineの概要が紹介されました。さくらインターネットが掲げるさくらのAIは、単一サービス名ではなく、同社が今後AI領域へ本格的に取り組む姿勢を示すための総称です。その中心となるのがさくらのAI Engineです。

近年、生成AIの導入が進む中、多くの企業で課題となるのが「利用コストの見通しをどう立てるか」です。生成AIは業務のさまざまな場面で活用されるようになり、従量課金による推論コストが積み上がりやすくなります。こうした課題に対し、さくらインターネットが提供する選択肢の一つがGPUの占有による月額固定化です。占有GPUの上にオープンソースやオープンウェイトのモデルを載せれば、推論コストを変動費から固定費へ切り替えることができ、企業はAI利用を投資として計画しやすくなります。

一方で、占有GPUプランは初期コストが高く、いきなり導入するにはハードルがあります。そこでまずは従量課金で必要な分だけ使えるさくらのAI Engineを起点に小さく始め、利用が広がってきた段階で占有GPUへ移行する、といった段階的な導入も取りやすくなっています。企業の規模や用途に応じて柔軟に選べる点は、AI Engineを採用する大きなメリットの一つです。

また、データの取り扱いについても明確なポリシーがあります。AI Engineで利用できるモデルはすべて石狩データセンター内でホスティングされており、推論も同センター内で完結します。外部クラウドにデータを送ることに慎重な企業にとっても安心して利用できる構成です。いわゆるローカルLLMに近いこの構成は、外部クラウドへデータを送信することに慎重な企業にとって、セキュリティポリシーを損なわずに生成AIを導入できる安心材料となります。

ローカル LLMを取り巻く技術の変化

かつてはローカルLLMは精度が不十分という印象もありましたが、現在は状況が大きく変わっています。その背景にあるのが量子化と呼ばれる技術です。量子化技術の進展により、モデルの軽量化・高速化が進み、精度も維持されるようになりました。さらに、OpenAIが公開したChatGPTのオープンウェイトモデルGPT-OSS(20B/120B)が高い性能を示しており、企業利用にも十分耐える選択肢として注目されています。さくらのAI EngineにもGPT-OSS-120Bを含む複数のモデルが搭載されていますが、今後はGPT-OSSを採用するケースが増えていくと見込まれます。

こうしたモデル選択に加えて、AI Engineを特徴づけているのがRAGによるDocument機能です。RAGは外部のナレッジを参照しながら応答を生成する仕組みで、知識を準備する段階のモデルと、実際に回答を返すモデルの二つが協調して動作する点が特徴です。まず事前準備では、文書を「埋め込み(Embedding)」モデルで多次元ベクトルに変換し、検索可能なデータとして保存します。埋め込みは、一般的に768次元や1024次元といった大きなベクトル空間で行われ、通常であればpgvectorやOpenSearch、TiDBなどのベクトルストアを自前で準備する必要があります。しかしAI EngineのDocument機能を使えば、文書をアップロードするだけでチャンク分割からベクトル化、保存までが自動で行われます。

こうして準備されたナレッジに対し、ユーザーが質問すると、その質問文も同じ方法でベクトル化され、数学的に最も近いベクトルが検索されます。返されるのは数値そのものではなく、ベクトル化される前の元文書で、これがRAGにおける「外部知識」として機能します。たとえば「猫・犬・イルカ」をベクトル化した場合、猫と犬が近く、イルカが離れるように、意味的な距離を数値で扱えるのがベクトル検索の特徴です。

最終的には、検索で得た文書をLLMが読み取り、自然な文章として整形して返します。本来であれば複数ステップのAPI呼び出しが必要になるところ、AI EngineのDocument機能を使えば、この一連の処理をワンストップで実行できます。内部処理を意識せず利用できるため、生成AI導入時の設計・運用の負担を大きく軽減できる点は、参加者からも高く評価されていました。

ハンズオン

ハンズオンは、こちらの記事を参照にまず外部知識ベース(RAG)の元となるPDF文書をAI Engineに登録するところから始めました。今回は、例として個人情報の保護に関する基本方針をまとめた政府文書のPDFを用意し、AI Engineのドキュメント機能に登録しました。

PDFをアップロードすると、AI Engineによって自動的にチャンク化と埋め込みが行われ、検索可能なナレッジとして保存されます。外部にベクトルストアを準備する必要はなく、数ステップでRAGの基盤が整う点は参加者にも扱いやすく感じられていました。

LINE Botとは

LINEヤフーの立花さんより、LINE Botの概要が紹介されました。LINE Botは、LINE公式アカウントにMessaging APIを有効化することで外部システムと連携させて動作する仕組みです。新しいUIを設計しなくても、すでに使い慣れたLINEのインターフェース上でサービスを提供でき、利用開始のハードルが低いことが特徴です。開発者が日常的に扱う多くの公式アカウントはこの機能を使ってBot化されたもので、今回構築するものも同じ形式にあたります。

LINE Botを採用する背景には、サービスを素早く立ち上げられる利点があります。ユーザーインターフェースをあらためて設計する必要がなく、開発者は体験づくりそのものに集中できます。ユーザー側も新しいアプリをインストールしたりログインフローを踏んだりする必要がなく、普段使っているLINE上で自然にサービスを使い始められるため、導入のハードルがきわめて低いのが特徴です。通知やメッセージも日常の延長で受け取れるため、サービスとの接点を維持しやすい側面もあります。

こうした特性から、LINE Botは企業業務から生活サービスまで幅広い分野で活用されています。ECや予約管理、CRMなど業務の一部を担うものから、リマインダーや割り勘、ゲームといった日常向けのもの、さらにはAIチャットボットや占いサービスといった対話型の体験まで、提供されるサービスの幅は年々広がっています。公式サイトにも多様な事例が公開されており、LINEを入口としたサービス設計の広がりが感じられます。

ハンズオン

さくらのAI Engineをつなぎ込むための実装手順が紹介されました。ここでは、エンドユーザーが日常的に使っているLINEをノーコードツールのMake.comと組み合わせながら、LINE Botに届いたメッセージを外部サービスへ渡し、その応答を返す最小構成をこちらの記事を元に構築しました。

まずは、LINE Botに届いたメッセージをどのように外部サービスへ渡し、応答として返すのかを、Make.comを使って実際に確認していきます。Makeはノーコードで処理フローを構築できるサービスで、LINEとの連携とも相性がよいツールです。

新しいシナリオを作成し、最初のモジュールとしてLINE – Watch Eventsを配置します。ここに取得済みのアクセストークンを設定すると、Makeが発行するWebhook URLが利用可能になります。このURLをLINE Developersコンソールに登録することで、Botに届いたメッセージがMake側へ転送されるようになります。

続いてLINE – Send Reply Messageモジュールを追加し、replyTokenを使った簡単な応答処理を設定します。ここまで構成すると、LINE → Make → LINEの往復が成立する最小構成が完成します。Run onceを実行し、自分のLINEからBotにメッセージを送ると、返信が正しく返ってくることを確認できます。そして、さくらのAI Engineと連携させ、より実用的なボットへと拡張していきます。

学校給食検索Bot

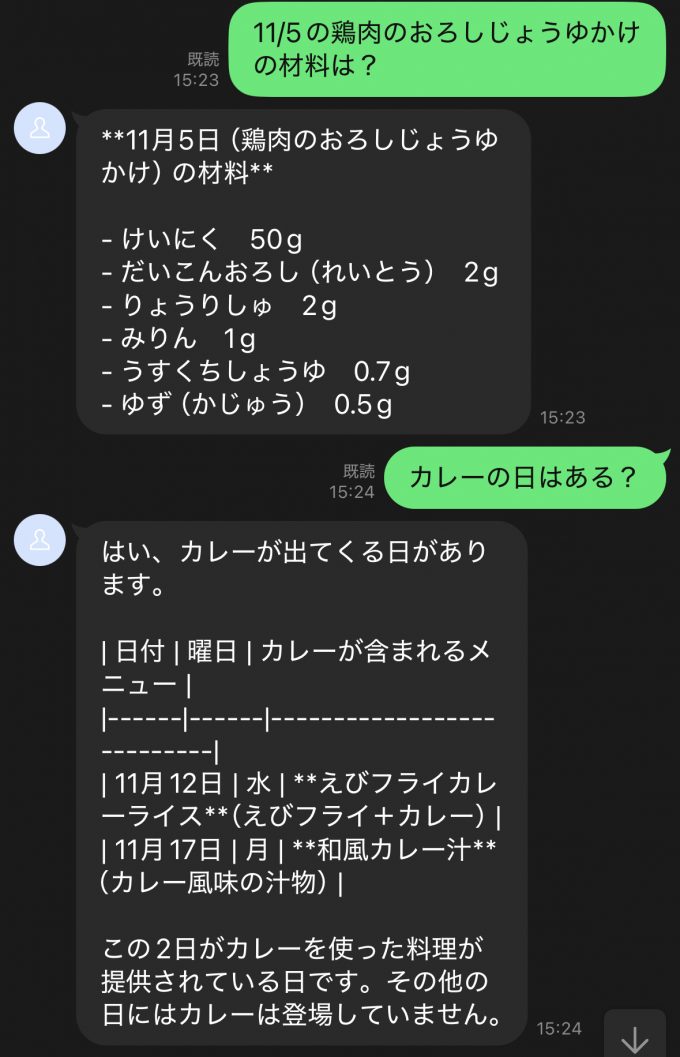

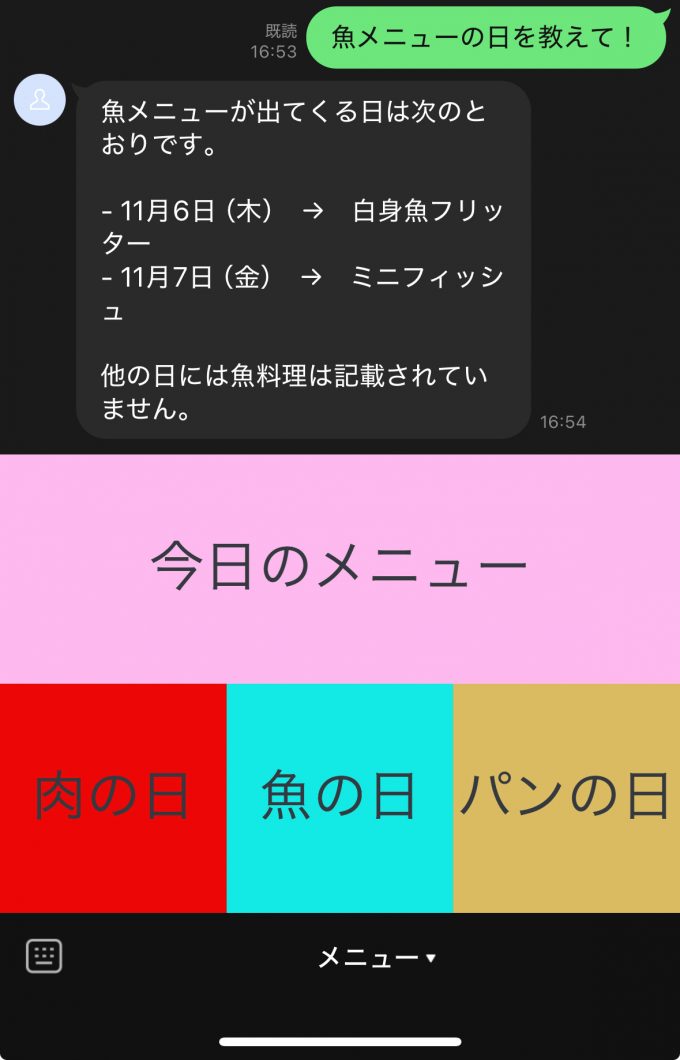

大阪市が公開している学校給食データを題材に、利用者が LINE上から「今日のメニュー」や「使われている材料」を尋ねると、Botが自動で回答してくれる仕組みを構築しました。

まずは給食データをAI Engineに登録します。これをMake.comから利用するため、先ほどのシナリオにAI Engine のdocuments/chatエンドポイントを呼び出すHTTPモジュールを追加します。ユーザーが送ったメッセージ(例:「今日のメニューを教えて」)をそのままAI Engineに渡し、検索結果と生成AIによる回答を受け取り、それを LINE Botの返答として返す構成です。

設定後、Run onceを使って実際にBotに話しかけると、

- 「今日のメニューは?」

- 「鶏肉のおろし醤油かけの材料は?」

といった質問に対し、登録したPDFの内容にもとづいた回答が自然な文章で返ってきます。

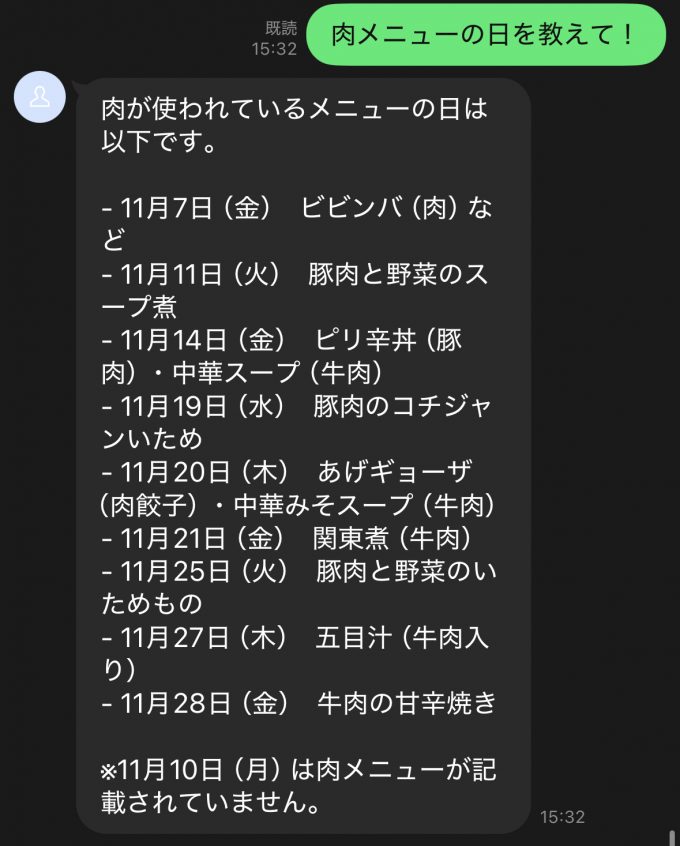

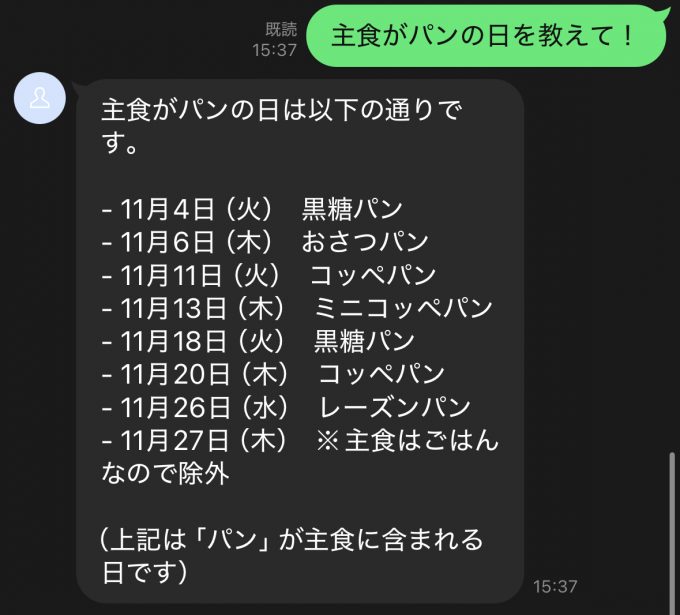

外部データと生成AIを組み合わせたRAGの仕組みは、これまで複雑な構築が必要とされるものでしたが、AI EngineとMake.comの組み合わせによって、LINE Botという身近なインターフェースの中にスムーズに組み込むことができました。さらに、Botをより迷わず利用できるようにするための工夫として、リッチメニューの設定方法も紹介されました。リッチメニューは、LINE公式アカウントの画面下部に表示される大きな操作パネルで、タップだけでBotにメッセージを送れる仕組みです。

LINE公式アカウントマネージャーでリッチメニューを作成し、各領域に「今日のメニュー」「肉の日」「魚の日」といったアクションを割り当てていきます。これにより、ユーザーはメッセージを入力しなくても必要な情報へスムーズにアクセスできます。

リッチメニューを設定すると、Botが単なるチャットの延長ではなく、日常的に使えるサービスの入口として機能し始めるのが分かります。特に学校給食のように、保護者・児童など幅広い層が利用する場面では、ワンタップで操作できる導線があるだけで、使い勝手が大きく変わります。

まとめ

今回のハンズオンでは、さくらのAI EngineとLINE Botを組み合わせることで、生成AIを実際に使えるサービスとして届けるまでのプロセスを一通り体験しました。

PDFを登録するだけでRAGの基盤が整い、Make.comを通じてLINE上のインターフェースに無理なく組み込めること、さらにリッチメニューを加えることで利用者の操作性が大きく高まることを確認できました。

生成AIは単体の技術ではなく、サービス設計・データ管理・インターフェースの工夫といった複数の要素が連動して初めて価値を発揮します。今回の取り組みは、そうしたAIを社会に届けるための実装を身近に感じられる機会となりました。

ハンズオンの締めくくりには参加者によるLTも行われ、実際に構築したBotの紹介や活用例が共有されるなど、会場は大いに盛り上がりました。